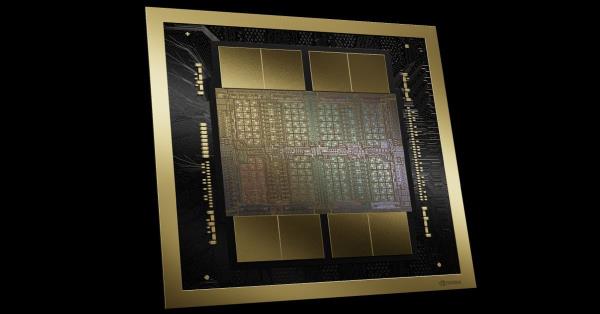

英伟达必备的H100人工智能芯片使其成为一家价值数万亿美元的公司,其价值可能超过Alphabet和亚马逊,竞争对手一直在奋力追赶。但也许英伟达即将扩大其领先地位——凭借新的Blackwell B200 GPU和GB200“超级芯片”。

英伟达表示,新的B200 GPU从其2080亿个晶体管中提供高达每秒20千万亿次的FP4马力。此外,它还表示,将两个gpu与单个Grace CPU结合在一起的GB200可以为LLM推理工作负载提供30倍的性能,同时也可能大大提高效率。英伟达表示,与H100相比,它“降低了高达25倍的成本和能耗”。

英伟达称,之前训练一个1.8万亿参数的模型需要8000个Hopper gpu和15兆瓦的功率。今天,英伟达的首席执行官表示,2000个Blackwell gpu可以在消耗4兆瓦的情况下完成这一任务。

在拥有1750亿个参数的GPT-3 LLM基准测试中,英伟达表示,GB200的性能是H100的7倍,训练速度是H100的4倍。

英伟达告诉记者,关键的改进之一是第二代变压器引擎,通过每个神经元使用4位而不是8位,使计算、带宽和模型大小翻了一番(因此,我之前提到的FP4每秒20千万亿次浮点运算)。第二个关键的区别是当你把大量的gpu连接在一起时:下一代NVmeta交换机可以让576个gpu相互通信,每秒1.8 tb的双向带宽。

这需要英伟达打造一个全新的网络交换芯片,其中包含500亿个晶体管和一些自己的板载计算:每秒3.6万亿次浮点运算的FP8,英伟达说。

此前,英伟达表示,一个只有16个gpu的集群将花费60%的时间用于相互通信,只有40%的时间用于实际计算。

当然,英伟达希望公司大量购买这些gpu,并将它们封装在更大的设计中,比如GB200 NVL72,它将36个cpu和72个gpu插入到一个液冷机架中,总共可以实现每秒720千万亿次的人工智能训练性能或每秒1440千万亿次的推理性能。它内部有近两英里长的电缆,有5000条单独的电缆。

机架中的每个托盘包含两个GB200芯片或两个NVmeta开关,每个机架有18个GB200芯片和9个NVmeta开关。英伟达表示,其中一个机架可以支持27万亿参数模型。传闻GPT-4是一个约1.7万亿参数模型。

该公司表示,亚马逊、谷歌、微软和甲骨文都已经计划在他们的云服务产品中提供NVL72机架,尽管目前还不清楚他们购买了多少。

当然,英伟达也很乐意为企业提供其余的解决方案。这是DGX GB200的DGX Superpod,它将八个系统结合在一起,总共有288个cpu, 576个gpu, 240TB内存和11.5 exaflops的FP4计算。

英伟达表示,其系统可以扩展到数以万计的GB200超级芯片,通过其新的Quantum-X800 InfiniBand(最多144个连接)或Spectrum-X800以太网(最多64个连接)连接在一起,形成800Gbps的网络。

我们预计今天不会听到任何关于新的游戏GPU的消息,因为这个消息来自英伟达的GPU技术会议,该会议通常几乎完全关注GPU计算和人工智能,而不是游戏。但Blackwell的GPU架构也可能会为未来的RTX 50系列桌面显卡阵容提供动力。