人工智能技术的快速发展,特别是大语言模型的应用,正在深刻改变信息的生产和传播方式。 通过深度学习和自然语言处理的创新融合,统一钱文等智能系统能够理解并生成高质量的文本内容。 本文将重点关注AIGC核心的大语言模型的工作机制和实际应用,揭示这一颠覆性技术如何重塑信息时代的内容创作生态。

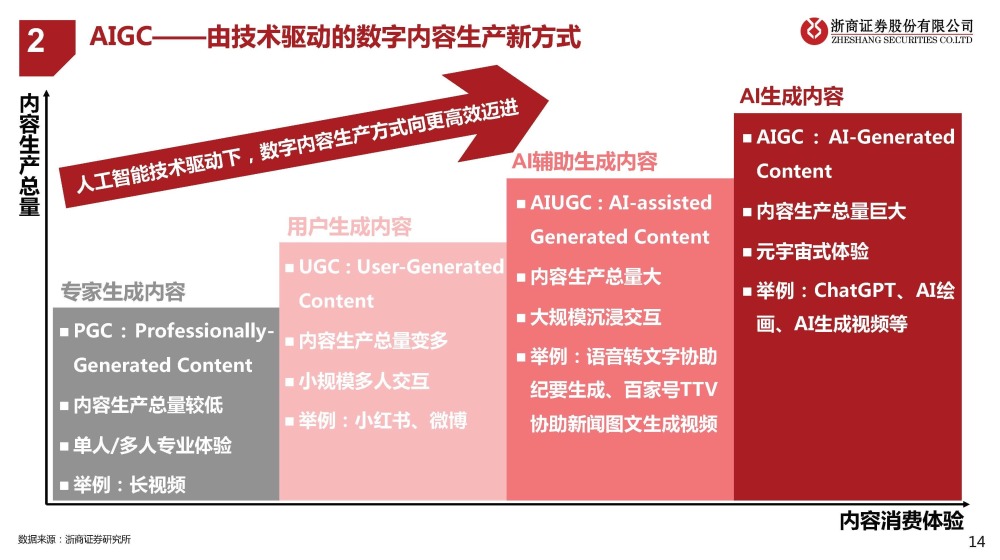

说起近一年来的热门科技词汇,AIGC当之无愧位列其中。

但你真的了解AIGC吗?

从某一天开始,我们突然发现AI可以生成文字、图片、音频、视频等内容,而且很难区分其背后的创造者是人类还是AI。

这些AI生成的内容被称为AIGC,即“AI”,AI生成内容的缩写。 生成的文章、生成的代码、生成的图片等均属于AIGC。

1. 生成式AI与相关领域的联系

虽然AIGC这个词在中国很流行,但另一个词AI,即生成式AI,在海外更流行。 从字面来看,生成式AI和AIGC之间的关系很容易理解。 生成式AI生成的内容就是AIGC。 所以诸如 、 、 等都属于生成式人工智能。

可以看出,AIGC和生成式AI的概念非常简单明了。

然而,由于 AIGC 一词在中国比生成式 AI 更流行,因此 AIGC 在许多情况下也被用来指代生成式 AI。

那么生成式AI与AI、机器学习、监督学习、无监督学习、强化学习、深度学习、大语言模型等词语有什么关系呢? 你有没有感觉剪完东西之后还是很乱? 这个很难一言以蔽之,但是通过一张图你可以直观的了解到它们之间的关系。

人工智能(AI),也称为人工智能,是计算机科学下的一门学科,旨在让计算机系统模拟人类智能来解决问题和完成任务。

早在1956年,人工智能就被确立为一个学科领域,并在随后的几十年里经历了多轮低谷和繁荣。

2. 机器学习

机器学习是人工智能的一个子集。 其核心在于,它不需要人类进行显式编程,而是让计算机通过算法来学习和改进自己,以识别模式、做出预测和决策。

例如,如果我们通过代码告诉计算机图片中的红色是玫瑰花,而图片上有描述是向日葵,那么程序对花类型的判断就是通过人类直接编写的逻辑来实现的。 它不属于机器学习,机器什么也没学到。

但如果我们给计算机大量的玫瑰花和向日葵的图片,让计算机自己识别模式、总结规则,使其能够预测和判断未见过的图片,这就是机器学习。

机器学习领域有很多分支,包括监督学习、无监督学习和强化学习。

在监督学习中,机器学习算法接收带标签的训练数据,标签就是期望的输出值。 因此每个训练数据点都包含输入特征和预期输出值。

算法的目标是学习输入和输出之间的映射关系,以便给定新的输入特征,可以准确地预测相应的输出值。

监督学习:

经典的监督学习任务包括分类(将数据划分为不同的类别)和回归(进行数值预测)。

例如,拍一堆猫和狗的照片以及照片对应的“猫”和“狗”标签进行训练,然后让模型根据未见过的照片来预测它是猫还是狗。 这就是分类。

将一些房屋特征的数据,比如面积、卧室数量、是否有阳台等,以及对应的房价作为标签进行训练,然后让模型根据未见过的房子的特征来预测房价——这就是回归。

无监督学习:

无监督学习和监督学习的区别在于它学习的数据没有标签,因此算法的任务是独立发现数据中的模式或规则。

经典的无监督学习任务包括聚类,即对数据进行分组。

例如,取一堆新闻文章,让模型根据主题或内容的特征自动组织相似的文章。

强化学习:

强化学习允许模型在环境中采取行动并获得结果反馈。

从反馈中学习,以便您可以在特定情况下采取最佳行动,以最大化回报或最小化损失。 所以就像小狗一样,刚开始的时候,小狗会按照自己的意愿做很多动作,但是随着它和训狗师的互动,小狗会发现有些动作可以得到零食,有些动作却得不到零食。 某些行为甚至会受到处罚。

通过观察行动与奖惩之间的联系,小狗的行为会逐渐接近训练者的期望。

可以应用强化学习。

在许多任务中,比如让模型下围棋,它可以获得不同动作带来的奖励或损失的反馈,从而优化游戏中的策略并学习如何采取行动以获得高分。

3.深度学习的方法与应用

那么问题来了:深度学习属于这三个类别中的哪一个?

——它们属于里面的任何类别!

深度学习是机器学习的一种方法。 其核心是利用人工神经网络模仿人脑处理信息的方式,通过层次化的方法提取和表示数据的特征。

神经网络由许多称为神经元的基本计算和存储单元组成。

这些神经元通过层层连接处理数据,深度学习模型往往有很多层,因此变得很深。

例如,您想要求计算机拍摄小猫的照片。 在深度学习中,数据首先传递到输入层,就像人眼看到图片一样,然后数据传递到多个隐藏层。

每层对数据执行一些复杂的数学运算,以帮助计算机理解图像中的特征,例如小猫的耳朵、眼睛等。最后,计算机输出一个答案,表明这是否是小猫的图片。

神经网络可用于监督学习、无监督学习和强化学习,因此深度学习不属于它们的子集。

生成式人工智能是深度学习的一种应用。 它使用神经网络来识别现有内容的模式和结构并学习生成新内容。 内容可以是文字、图片、音频等形式。

4. 大语言模型(LLM)

大语言模型“Large”,简称LLM,也是深度学习的一种应用,专门用于自然语言处理任务。

大语言模型中的大字表明模型的参数数量非常多,可能是数十亿甚至万亿,并且训练过程也需要海量的文本数据集,因此可以更好地理解自然语言并生成高质量的文本数据集。文本。 。

大语言模型的例子有很多,比如国外的GPT、LLaMA、国内的ERNIE等,都可以理解并生成文本。

以GPT-3模型为例,它会根据输入提示和之前生成的单词,通过概率计算逐步生成下一个单词或token,输出文本序列。 如果你想了解更多大语言模型背后的原理,可以观看下一个视频。

但并非所有生成式人工智能都是大型语言模型,并且对于是否所有大型语言模型都是生成式人工智能存在一些争议。

前半句话很容易理解。 生成图像的扩散模型并不是一个大型的语言模型。 它不输出文本。 同时,也有人认为并非所有大型语言模型都是生成式AI,因为一些大型语言模型由于其架构特点并不适合文本生成。

谷歌的 BERT 模型就是一个例子。 它具有大量的参数和序列数据,是一个大型语言模型。

在应用方面,BERT具有很强的理解上下文的能力,因此被谷歌用于搜索,以提高搜索排名和信息摘录的准确性。 它还用于情感分析和文本分类等任务。 但与此同时,BERT 并不擅长文本生成,尤其是连贯的长文本生成。 所以有人认为这类模型不属于生成式AI的范畴。

以上理念共同构成了AIGC的核心要素。 希望它可以帮助您更多地了解流行的AIGC。